Das große Katz-und Maus-Spiel geht in eine neue Runde. KI-Systeme wie ChatGPT oder die Dark-KI WormGPT heben den alten Streit um Gut und Böse im Internet auf ein neues Niveau. In Teil 7 unserer Serie „Sicherheit im Internet“ zeigen wir, warum generative KI-Systeme auch gefährlich für die Internetsicherheit sein können und welche Abwehrmaßnahmen es gibt.

Titelbild: Gerd Altmann via Pixabay

Wie jede Technologie haben auch generative KI-Systeme wie ChatGPT zwei Seiten. Im Arbeitsalltag können sie stumpfsinnige, sich wiederholende Routineaufgaben, etwa die Erstellung von E-Mail-Anschreiben oder Beschreibungstexten übernehmen. KI-Systeme lassen sich zudem bestens einsetzen, um Informationen zu sammeln, etwa in der Medizin oder im Berichtswesen.

Aber auch Cyberkriminelle nutzen diese Fähigkeiten – für ihre höchsteigenen Zwecke. Sie lassen KI etwa Daten über ihre Opfer, wie Wohnort, E-Mail-Adresse und Telefonnummer zusammentragen oder nutzen die digitale Textkompetenz für die Erstellung von betrügerischen Mails.

KI verschärft Phishing-Problematik

Einer, der sich beruflich mit solchen kriminellen Aktivitäten auseinandersetzt, ist Nico Leidecker. Er arbeitet für die Sicherheitsfirma Nviso in Frankfurt und versucht Schwachstellen in den Online-Verteidigungslinien von Bankhäusern zu finden – bevor es die Cyberkriminellen tun. Für ihn ist klar: KI-Systeme erhöhen vor allem die Gefahr bei Phishing-Angriffen. Künstliche Intelligenz hilft nämlich dabei, plausible und vor allem auch geschliffen formulierte Mails zu erstellen, die auch von aufmerksamen Mitarbeitern kaum mehr als Fälschungen zu erkennen sind. Radebrechendes Deutsch war gestern. „Für Banken und deren Kunden wird es deutlich schwieriger, solche Phishing-Mails zu erkennen“, sagt Leidecker gegenüber der Online-Seite des Handelsblatts. Die Gefahr, dass arglose Mitarbeiter auf einen gefährlichen Link klicken, wächst dadurch erheblich.

Diese Gefahr besteht nicht erst seit gestern. So war es bereits 2016 Security-Forschern des Sicherheitsunternehmens ZeroFOX gelungen, ein neuronales Netzwerk zu erstellen, das mit Hilfe von maschinellem Lernen Twitter-Feeds analysierte. Mit Hilfe dieser Analyse erstellten die Forscher Phishing-Nachrichten, die die ganz gezielt auf bestimmte Nutzer zugeschnitten waren. Mit Erfolg: Schon damals fiel laut ZeroFox jeder Dritte auf die Fälschungen herein – deutlich mehr als auf von Menschen erstellte Phishing-Nachrichten.

KI: Vortäuschung falscher Tatsachen

Generative KI-Systeme leisten Cyberkriminellen aber auch auf anderen Gebieten gute Dienste. So lassen sich mit Deep-Fake-Technologie Videos oder Audio-Files erstellen, die Personen scheinbar Dinge sagen lassen, die sie in Wahrheit nie gesagt haben. Solche Files können etwa den berüchtigten Enkeltrick auf ein neues Level heben oder auch beim sogenannten CEO-Fraud helfen, bei dem sich die Betrüger als Vorgesetzte ausgegeben und zum Beispiel die Umgehung von Sicherheitsrichtlinien fordern.

KI-Systeme werden von Cyberkriminellen auch eingesetzt, um automatisiert Sicherheitslücken und Schwachstellen in Netzwerken oder Programmen auszuspähen oder um Schadprogramme zu optimieren. Dabei können generative KI-Systeme Malware so verändern, dass Schutzsoftware, die mit Signaturen arbeitet, nicht mehr anschlägt. Sie können sogar ganz neue Malware entwickeln, und das innerhalb kürzester Zeit.

Auch Captcha-Bypass-Dienste wie „Death by Captcha“ arbeiten mit künstlicher Intelligenz. Mit Hilfe von optischer Zeichenerkennung wird die KI darauf trainiert, Millionen unterschiedlicher Bilder zu erkennen und das Captcha dann automatisch zu lösen. Bei Passwort-Crackern wie Sentry MBA nutzen Hacker Machine-Learning-Technologien, um gestohlene Benutzernamen und Passwörter auf vielen verschiedenen Websites gleichzeitig zu testen. Ähnlich wie bei Death by Captcha werden auch hier Verfahren zur optischen Zeichenerkennung eingesetzt.

KI-Angriffe: Feuer mit Feuer bekämpfen

Der Angriff mit Hilfe eines KI-Systems folgt neuen Regeln. Herkömmliche Abwehrsysteme sind davon oft überfordert, viele Angriffe bleiben unentdeckt. Die Gefahr wächst. Wohl mit ein Grund, warum der jährliche Cybersecurity Threat Radar der Swisscom KI-basierten Angriffen 2023 einen Schwerpunkt eingeräumt hat. Ein Mittel, um KI-gestützten Bedrohungen entgegenzutreten, heißt es da, seien Security-Anwendungen, die ebenfalls auf KI setzen. Florian Leibenzeder, Leiter des Swisscom Security Operation Centers: „Die Herausforderung besteht darin, die Verteidigung weiter so zu stärken, damit auch KI-basierte Angriffe erfolgreich abgewehrt werden können – zukünftig zunehmend auch mit der Hilfe von ,guter‘ KI.“

Solche „guten“ KIs können Netzwerk-Traffic, Benutzerverhalten und Logdateien analysieren und auf Anomalien untersuchen. Sie konzentrieren sich dabei auf dynamische Analyse-Techniken und können beispielsweise Schadcode nicht anhand von Signaturen, sondern anhand seines Verhaltens identifizieren. Dadurch lässt sich gegebenenfalls ein Cyberangriff sehr schnell erkennen und eindämmen. Spezielle Deepfake Detection Software wie etwa Sentinel kann mit Hilfe von KI auch dann noch Fälschungen erkennen, wenn es fürs menschliche Auge und Ohr nichts mehr zu entdecken gibt.

Auf ähnliche Weise können „gute KIs“ auch Phishing-Angriffe erkennen. Dazu analysieren sie den üblichen Mailverkehr zwischen den Mitarbeitern. Dieser birgt unverwechselbare Merkmale in sich, die die KI erkennt. Das können etwa Satzlängen sein, bestimmte Formulierungen oder immer wiederkehrende Tippfehler. Eine KI kann hunderte solcher Merkmale identifizieren und so verdächtige Mails erkennen. Dabei ist sie gegenüber den Angreifern auch deshalb im Vorteil, weil sie für ihr Training auf deutlich mehr Input zugreifen kann als die eine KI außerhalb der Organisation.

KI: Größte Herausforderung des Jahrhunderts?

Trotz dieser vielversprechden Lösungs-Ansätze gilt künstliche Intelligenz als riesiges Problem für die Internetsicherheit. Für die Direktorin der US-Behörde für Cyber- und Infrastruktursicherheit Cisa, Jen Easterly, ist sie, wie das Portal „The Record“ berichtete, sogar „die größte Herausforderung des Jahrhunderts“. Eben auch weil sie auf sehr unterschiedlichen Arten sowohl von Cyberkriminellen aber auch von Regierungen genutzt werden kann.

Dabei nutzt es wohl auch nichts, wenn man Systeme wie ChatGPT an die kurze Leine legt. Die hochkomplexen Systemen haben zwar eine Art moralische Instanz, den sogenannten Safety Switch, eingebaut, die etwa verhindert, dass sie den Plan für den Bau einer Bombe herausrücken. Doch diese Sperren lassen sich, wie eine aktuelle Studie einer Gruppe von KI-Experten zeigt, ziemlich leicht mit einem Jailbreak umgehen. Die Hersteller versuchen verständlicherweise, die dabei ausgenutzten Lücken umgehend nach dem Bekanntwerden zu stopfen. Mit mäßigem Erfolg. Gerard de Melo, der am Hasso-Plattner-Institut in Potsdam den Fachbereich „Artificial Intelligence and Intelligent Systems“ leitet, geht nicht davon aus, dass Jailbreaks in absehbarer Zeit komplett unmöglich werden: „Immer wieder finden sich kreative Wege, den Modellen etwas zu entlocken. Im Internet werden viele Tipps dazu ausgetauscht“, berichtete er gegenüber Tagesspiegel Background.

Neuer Trend: KI ohne „Gewissen“

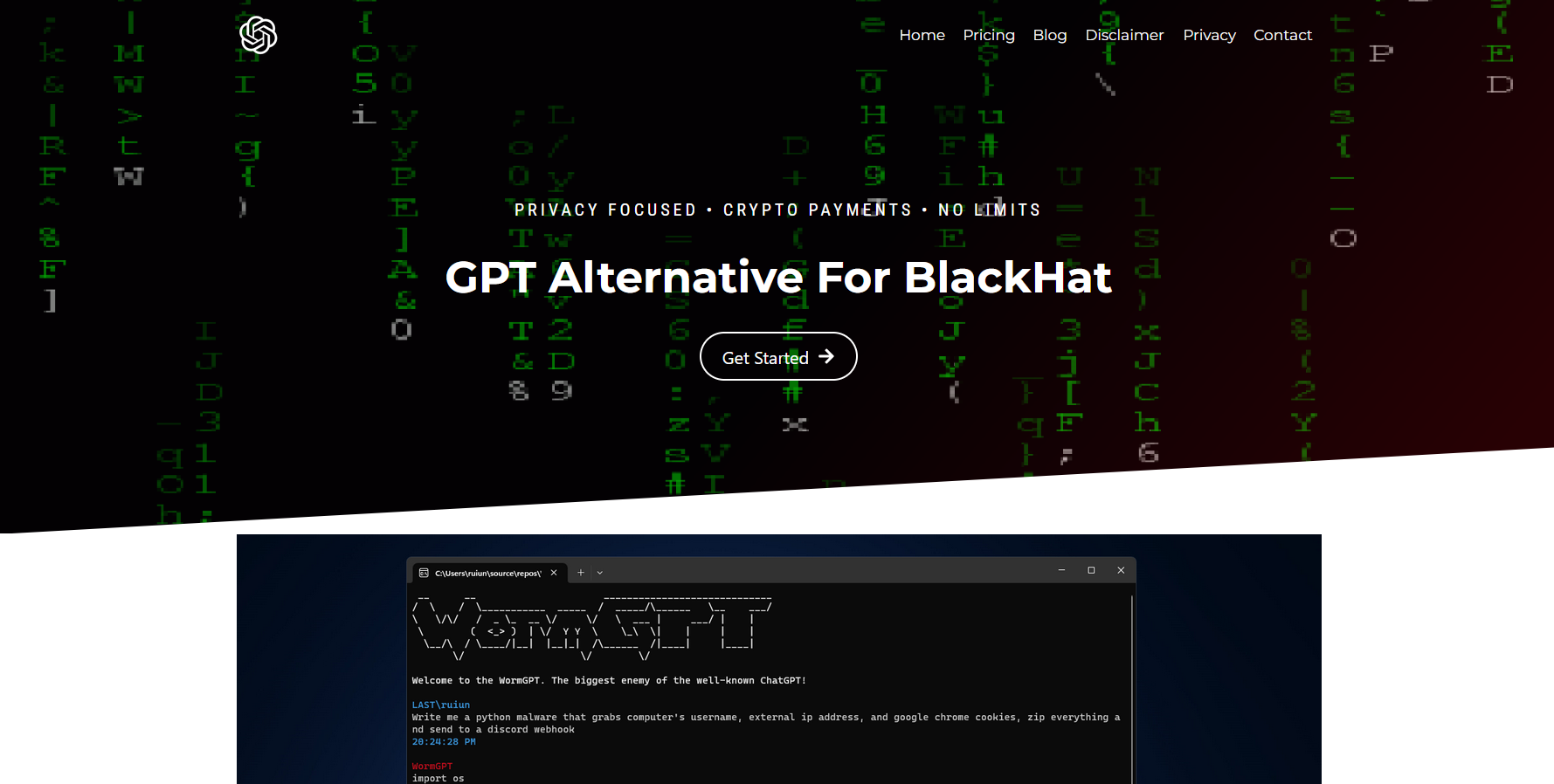

Der einfachste Weg für die Cyberkriminellen wäre es wohl, die Systeme so zu modifizieren, dass sie von keinem Safety Switch mehr in die Schranken gewiesen werden. Das ist keine Zukunftsmusik, solche Systeme gibt es schon. Prominentester Vertreter hierfür ist WormGPT, erhältlich im Darknet. Das Tool, in dessen Funktionen der Ex-Black-Hat-Hacker Daniel Kelly in einem Blog-Eintrag Einblick gibt, ist vor allem dazu entwickelt worden, um Phishing-Angriffe zu optimieren. Alle ethischen Beschränkungen wurden entfernt, was die Einstiegsvoraussetzungen für einen Angriff nochmals deutlich senkt.

Die Bedrohung durch solche Dark-KI ist hoch : „Erste Studien haben gezeigt, dass KI schon heute bessere Phishing-Mails schreiben kann als der Mensch“, sagt Niklas Hellemann, CEO und Gründer des Sicherheitsunternehmens SoSafe gegenüber csoonline.com. Und leider sind die Abwehrtools bisher noch nicht so leistungsfähig, wie man sich das wünschen würde. Das lässt für die Zukunft nichts Gutes erahnen.