Aufmacherbild: (C) Steve Jurvetson – ursprünglich auf Flickr unter dem Titel „Hands-free Driving“, CC BY 2.0

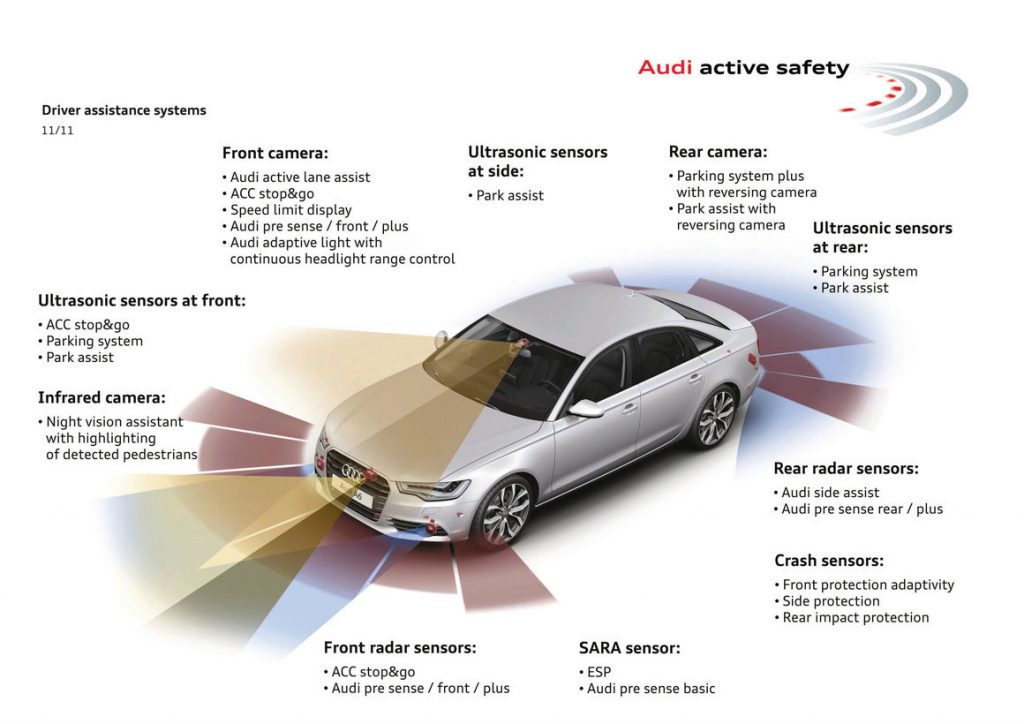

Um in Zukunft autonom fahren zu können, brauchen Autos ein für ihre Bordcomputer verständliches und möglichst genaues Abbild ihrer Umwelt. Sie benötigen Informationen über den exakten Straßenverlauf inklusive Spurführung und temporären Sperrungen, über Verkehrsschilder und Ampeln, über die vor, neben und hinter dem eigenen Vehikel fahrenden Fahrzeuge sowie nicht zuletzt über mögliche Hindernisse vom Wildwechsel bis zu Radfahrern oder Fußgängern. Selbst wenn letztere, etwa auf Autobahnen, aus rein verkehrsrechtlicher Sicht eigentlich nicht zu erwarten wären. Die Augen und Ohren autonomer Fahrzeuge sind hochspezialisierte Sensoren. Und in deren Realisation fließt jede Menge Forschungs- und Entwicklungsarbeit ein.

So wie das autonome Fahren selbst ist auch die Entwicklung der dafür eingesetzten Sensorik ein langer Prozess mit vielen Zwischenschritten. Fahrzeuggeneration nach Fahrzeuggeneration nähert sich der Idee vom selbst fahrenden Auto schrittweise an. Immer ausgeklügeltere Assistenzsysteme mit immer ausgeprägterer Eigenintelligenz übernehmen immer mehr Steuerungfunktionen für immer längere Zeiträume. Und weil das autonome Fahren wesentlich von ihrer Leistung abhängt, lohnt sich ein genauerer Blick auf die Sensor-Systeme und die Schwerpunkte bei ihrer Weiterentwicklung.

Ultraschall-Sensoren gibt’s schon lange – doch sie lernen ständig dazu

So hatte auch die Bordsensorik vergleichsweise bescheidene Anfänge. Zum Schutz gegen Parkrempler eingesetzte Ultraschall-Sensoren gibt es schon seit mehr als 20 Jahren. In heutigen Autos und denen der nächsten Jahre wachsen ihre Aufgaben deutlich: So ist die Nahfeldüberwachung mittlerweile auch Basis für vollautomatisches Einparken – mit oder ohne Fahrer an Bord.

Ultraschall-Sensoren senden Schallwellen oberhalb des menschlichen Hörbereichs aus. Diese werden von Hindernissen größenteils reklektiert, zu einem Teil aber auch absorbiert. Die reflektierten Anteile werden von einem anderen Element in der Sensor-Baugruppe wieder aufgefangen. Anhand von Phasenlage und Amplitude lässt sich der zeitliche Versatz zwischen Aussendung und Eintreffen ermitteln – und somit die Entfernung zum Hindernis berechnen.

Dass die Ultraschall-Technik keineswegs „ausentwickelt“ ist, beweist beispielsweise das Münchener Startup Toposens, das Ultraschall-Sensoren und die zugehörige Software für hoch aufgelöste 3D-Umfelderkennungen entwickelt. Mit dem aktuellen Stand ihrer Technik erkennen die Münchener Jungwissenschaftler bereits Objekte mit einer Genauigkeit von 5 bis 10 Millimetern in einem Bereich von 30 cm bis zu maximal 8 Metern. Im Herbst 2016 soll ein Development-Kit für interessierte Kunden verfügbar sein. Die Autoindustrie betrachten die Firmengründer dabei als eine ihrer Kernzielgruppen.

Im Rahmen des „Startup Talks München“ präsentieren sich die Toposens-Gründer in knapp vier Minuten Video selbst:

Von Fahrspurerkennung bis zum räumlichen Sehen – die rasante Entwicklung von Bordkameras

Wenn es darum geht, Autos auf weitere Entfernungen das „Sehen“ beizubringen, sind Kameras die erste Wahl. Tatsächlich finden sich heute selbst in der unteren Mittelklasse bereits Kameramodule, die im oder unter dem Rückspiegelgehäuse eingebaut sind und durch die Frontscheibe in Fahrtrichtung schauen. Sie dienen etwa der Erkennung von Fahrspuren bei Spurhalteassistenten, der Verkehrszeichenerkennung und zum Teil auch der Identifikation von Hindernissen.

Dabei sind sie für die meisten Anwendungen nicht auf sich allein gestellt: Schon heute werden die digitalen Kamerabilder von den Bordsystemen mit anderen Sensorinformationen und weiteren im Fahrzeug vorliegenden Daten abgeglichen. Die Software führt dann Plausibilitätsprüfungen durch, um zum Beispiel mögliche Falsch-Erkennungen zu korrigieren. Lässt sich etwa aus dem Kamerabild nicht allein entscheiden, ob das erkannte Verkehrszeichen 50 oder 80 km/h erlaubt, hilft ein Blick ins digitale Kartenmaterial und gegebenenfalls auf einen Karten-Server in der Cloud. Dabei berücksichtigt der Algorithmus auch den Kontext: Befindet sich das Fahrzeug innerorts (was für 50 km/h spräche) oder außerorts (was die Wahrscheinlichkeit von 80 km/h erhöht)? Mit Anbindung an einen Cloud-Server lässt sich sogar berücksichtigen, welche Verkehrszeichen andere Fahrzeuge an dieser Position gemeldet haben. Systemanbieter wie Bosch oder Continental setzen zunehmend auf Cloud- und Big-Data-Techniken, um solche Fragen möglichst zuverlässig zu beantworten.

Soll eine Kamera ähnlich wie ein menschlicher Fahrer auch den Abstand zum vorausfahrenden Fahrzeug oder anderen erkannten Objekten ermitteln, klappt dies erheblich besser, wenn Stereoskopie zum Einsatz kommt. So wie der Mensch zwei Augen zum räumlichen Sehen nutzt, können zwei separate Kameras durch intelligente Bildanalyse-Algorithmen recht exakt Entfernungen und Abstände berechnen.

Auch in diesem Bereich haben die Entwicklungsabteilungen der Autohersteller und Auto-Zulieferer die Nase vorn. Doch sie wiederum stützen sich auf Ergebnisse und Projekte von Hochschulen wie dem Institut für Mess- und Regelungstechnik an der Universität Karlsruhe, wo etwa an den Bilderkennungsalgorithmen, aber auch an Detailproblemen wie der kontinuierlichen Selbstkalibrierung von Kameras geforscht wird.

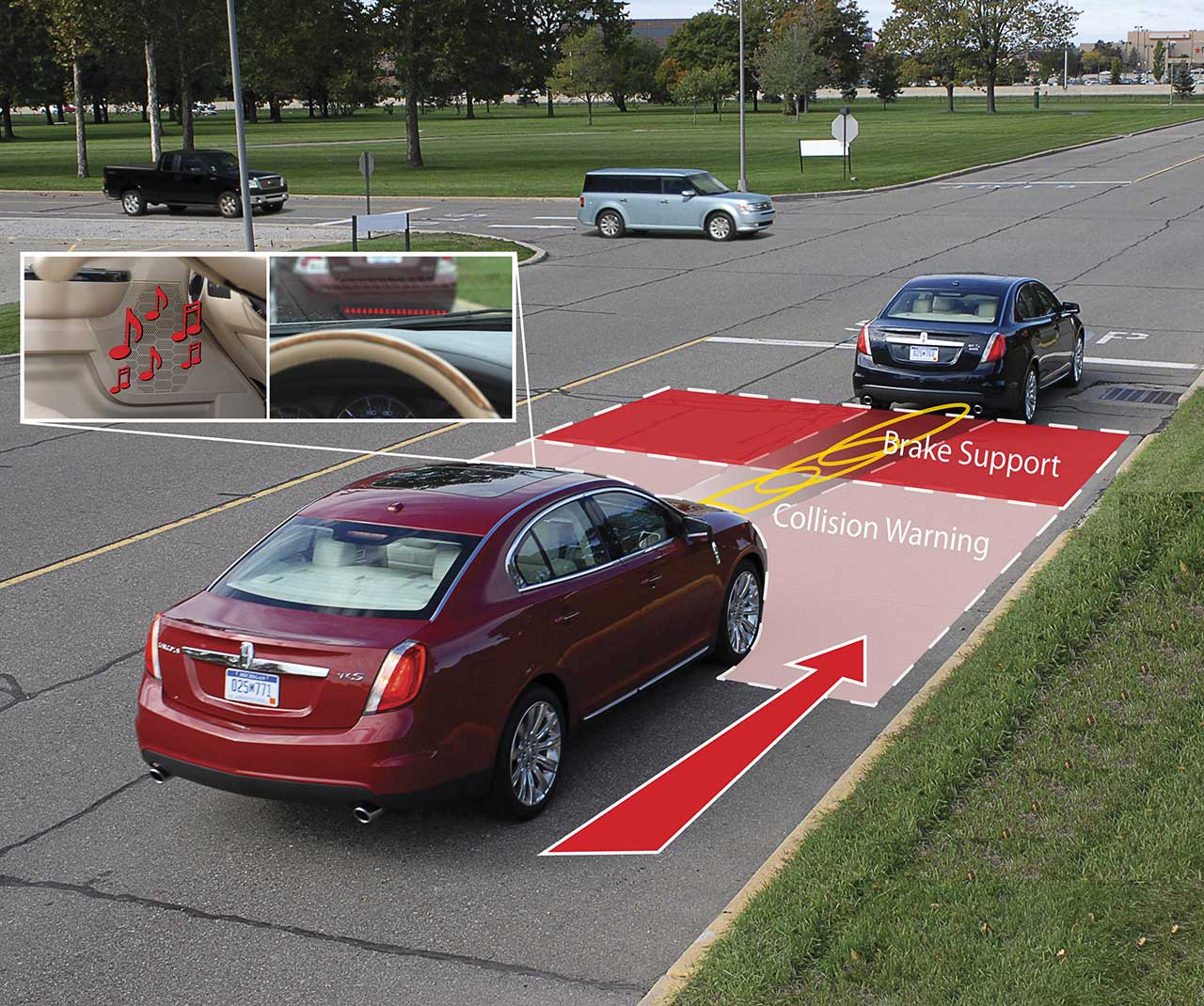

Radar-Sensoren stecken heute schon in der Mittelklasse

Mit Assistenzsystemen wie Tote-Winkel-Warnern, Abstandsregeltempomaten und Kollisions-Frühwarn- und Vermeidungssystemen hielten Radarsensoren in Pkws Einzug. Ältere Systeme decken ihren Erfassungsbereich mit drei Radarstrahlen beziehungsweise „-keulen“ ab, neuere Systeme setzen sogar auf vier. So lässt sich der Bereich vor dem Fahrzeug (beziehungsweise bei Heck-Sensoren hinter dem Fahrzeug) bis zuu Nachbarspur erfassen. Ähnlich wie schon bei den Ultraschallsensoren fangen auch die Radarsensoren einen Teil der ausgestrahlten Radarwellen wieder auf – nämlich den Anteil, der von vorausfahrenden beziehungsweise benachbarten Fahrzeugen reflektiert wurde.

Übrigens müssen sich Autofahrer keine Sorgen machen, während der Fahrt von anderen Autos mit gefährlichen Strahlendosen bombardiert zu werden. Die erwähnten Radarsensoren arbeiten mit einer Leistung von typischerweise 10 Milliwatt. Im Vergleich dazu arbeiten etwa Radarsysteme der Flugsicherung im Bereich von Megawatt – und somit mit Leistungen, die rund 10 Millionen mal höher sind.

Wie zum Beispiel Google Radar und andere Sensoren bei seinem selbstfahrenden Auto nutzt, erklärt dieser rund 15-minütige, allerdings englischsprachige Videomitschnitt eines Fachvortrags des zuständigen Entwicklungsteams:

Objekterkennung und Abstandsmessung nutzen dabei den sogenannten Doppler-Effekt: Das empfangene, also von Objekten im Abtastbereich reflektierte, Signal hat eine leicht unterschiedliche Wellenlänge als das von den Sensoren ausgestrahlte Signal. Wenn sich das Objekt auf den Sender zu bewegt, erhöht sich die Frequenz der reflektierten Welle. Wenn sich das Objekt vom Sender wegbewegt, wird die Frequenz der reflektierten Welle niedriger. Diesen Effekt hatte der Astronom Christian Doppler bereits 1842 beobachtet. Albert Einstein inspirierte dieser Effekt zur Entwicklung seiner speziellen Relativitätstheorie. Doch auch wenn die Grundlagenforschung hier schon über hundert Jahre alt ist – noch immer optimieren Ingenieure und Forscher die daraus abgeleiteten Kfz-Radar-Systeme. Die aktuell jüngste Generation von „Adaptive Cruise Control“-Systemen bietet einen Erfassungsbereich von 0,5 bis 200 Metern und einen Regelbereich von 0 bis 200 km/h. Sie erlauben somit sogar Staufolge-Assistenten, die das Fahrzeug komplett abbremsen, gegebenenfalls den Motor ausschalten, und wenn es im Stau weitergeht selbständig wieder anfahren können.

Wie diese Funktion beispielsweise in einem aktuellen Mercedes funktioniert, zeigt dieses rund vierminütige Video:

Dafür, dass die nächste Generation solcher Sensoren noch leistungsfähiger und vielseitiger sein wird, sorgt unter anderem das Institut für Signalverarbeitung und Systemtheorie an der Universität Stuttgart. Hier zählen Radarsignalverarbeitung und Sensorfusion mit Bildverarbeitung, aber auch Machine Learning und Signal Processing zu den aktuellen Forschungsschwerpunkten.

Laseraugen fürs autonome Fahren – Lidar-Sensoren

Doch wenn das Sensorsystem auch Objekte neben der Fahrbahn identifizieren soll oder erkennen muss, ob das vorausfahrende Fahrzeug ein Pkw, Lkw oder Motorrad ist, stoßen Radarsensoren aufgrund ihrer Funktionsweise, Erfassungswinkel und Wellenlängen an ihre Grenzen. Deshalb stehen gerade fürs autonome Fahren sogenannte Lidar-Sensoren hoch im Kurs. Das Kürzel steht für „Light Detecion and Ranging“. Vereinfacht gesagt setzen Lidar-Systeme statt Radar oder Ultraschall auf Lichtwellen, typischerweise Infrarot-Laserstrahlen. Sie lassen sich aufgrund ihrer Wellenlänge wesentlich exakter fokussieren und auswerten als die genannten Alternativen.

Wie dieses System funktioniert, zeigt Anbieter und Auto-Zulieferer Velodyne in diesem knapp dreiminütigen Video:

Für den Fahrzeugeinsatz typische Lidar-Sensoren senden gleichzeitig bis zu 12 Laserstrahlen aus, die durch leicht unterschiedliche Wellenlängen und Phasenlagen unabhängige „Sendekanäle“ bilden. Eine identische Anzahl an Empfangskanälen fängt die von den angestrahlten Objekten reflektierten Strahlen wieder ein. Durch Auswertung der unterschiedlichen Laufzeiten lässt sich dabei sowohl die Entfernung als auch die Relativgeschwindigkeit der erfassten Objekte ableiten. Die typische Reichweite eines Lidar-Systems beträgt über 150 Meter, der Erfassungsbereich typischerweise 20 Grad. Dabei lassen sich bei aktuellen Systemen zwei unterschiedliche Objekte bei einer „Winkelauflösung“ von 3 Grad unterscheiden. Diese Winkelauflösung können die Sensor-Entwickler je nach Bedarf über die Strahlbreite anpassen.

Auch die Laserstrahlen von Lidar-Sensorarrays arbeiten im niedrigen Milliwatt-Bereich, sodass die Sorge unbegründet ist, Autobahnen und Landstraßen könnten zum Schlachtfeld für Laser-Duelle à la Krieg der Sterne oder Kampfstern Galactica werden.

Im Vergleich zum Radar, das nur punktuelle Informationen liefert, kann ein Lidar sogar die Kontur von Objekten erkennen. Auf Basis dieser Sensordaten können Algorithmen sehr präzise räumliche Modelle der Fahrzeugumgebung errechnen. Allerdings ist Lidar wesentlich störanfälliger als Radarsensoren – etwa durch Regen, Schnee oder Nebel. Zudem ist die Lidar-Technik derzeit noch deutlich teurer als Radar. Neben der Weiterentwicklung der Lidar-Sensoren an sich konzentrieren sich Forschungsaktivitäten sowohl bei Fahrzeugherstellern und ihren Zulieferern als auch an Hochschulen wie etwa dem Fachgebiet Fahrzeugtechnik an der TU Darmstadt oder dem Karlsruher Fraunhofer-Institut für Optronik, Systemtechnik und Bildauswertung (IOSB) vor allem auf die Algorithmik für die Auswertung der von Sensoren erfassten 3D-Umfeldinformationen.

Die Intelligenz kommt aus der Software – Algorithmen und Sensor Fusion verbessern die Erkennung

Und dies gilt nicht nur für Lidar und die anderen bislang beschrieben Sensortypen. Tatsächlich stecken Unternehmen und auch Forschungsinstitute heute den meisten Arbeits- und Forschungsaufwand in die Software, die zur Auswertung der Sensorsignale dient.

So beschäftigt sich etwa das Fraunhofer-Verbundprojekt „Systemforschung Elektromobilität“ ausdrücklich mit der algorithmischen Verbesserung kostengünstiger Sensoren. Der Grundgedanke: Im Rahmen der Massenproduktion ist es deutlich vorteilhafter, Einsparungen an der Anzahl und Komplexität der Sensoren vorzunehmen und deren Leistung stattdessen mit intelligenterer Software zu steigern. Das Prinzip orientiert sich ein wenig an Menschen mit Seh- oder Hör-Beeinträchtigungen – die bei Ausfall oder Einschränkung eines ihrer Sinne die anderen umso effizienter einsetzen.

Das Zauberwort in diesem Zusammenhang heißt „Sensor Fusion“ – also die Zusammenfassung und ergänzende Auswertung mehrerer Bordsensoren. So kann etwa die Leistung einer Radar-Abstandserkennung durch zusätzliche Analyse des Kamerasignals verbessert werden.

Ebenso lassen sich die Informationen der speziell für Assistenzsysteme und autonomes Fahren ausgelegten Sensoren durch weitere Informationen wie etwa ohnehin im Fahrzeug verbaute Trägheitssensoren ergänzen. Eigentlich benötigen deren Nick-, Gier- und Wank-Informationen vor allem Systeme wie ESP oder Pre-Sense-Unfallvermeidung. Doch wenn die Daten ohnehin über den fahrzeugeigenen Datenbus bereitliegen, kann der Bordcomputer dieselben Informationen auch nutzen, um als nicht hundertprozentig zuverlässig klassifizierte Ergebnisse der Kamera- oder Lidar-Auswertung zu verbessern.

Vor allem dies ist der Forschungsschwerpunkt der Zukunft: Erst durch Software und kluge Algorithmen ergibt sich aus den unterschiedlichen Sinnen eines teil- oder hochautonomen Fahrzeugs ein umfassendes und komplettes Bild seiner Umweld. Je besser dieses Kunststück den Forschern und Entwicklern gelingt, umso häufiger wird das selbst fahrende Auto in Zukunft seinen Fahrer entlasten können – sofern dieser seine Fahraufgabe an den Bordcomputer abgeben möchte.